I started using the image generation AI in September, when the weather was still hot. It will be four months in about two weeks.

The reason for this was that the intense summer heat had sapped his strength, making it difficult for him to walk around with his heavy photographic equipment in search of subjects.

I had been thinking that at 75 years of age, it was inevitable that my body would deteriorate, but the doctor threatened me with the possibility of Parkinson’s disease. No kidding! I am still determined to keep walking in search of subjects.

All my medications went straight into the trash and I concentrated on my diet.

I would not break down so easily. Now I have no trouble leading a normal life. I am walking and wandering again, camera in hand.

Well, that’s not the main issue. It is about how to use the image generation AI that I have started to use for my own expression and how to tame it.

To put it bluntly, there is always a big gap between what I want to express and the images produced by the AI. In short, AI is an idiot to me. After learning and studying the prompts, the images that AI currently produces are patterned, flimsy, and uninteresting.

Why?

The answer is simple.

AI has no emotion, and the original landscape, the starting point of creation, is probably unrelated to AI.

If this is the case, why don’t you start with your own painted or photographed works as a foundation?

As a preliminary step to implementing the text2image or image2image paradigm, first have AI load your own work.

On top of the loaded artwork, place the image you have prompted for. Then it can blend its own image into the generated image. In the end, CaptureOne, Lightroom Classic, Photoshop, and sometimes Liminar AI help me.

That said, a certain amount of trial and error is required to achieve satisfactory results.

This is a rough explanation, but this page will show the works created based on the above ideas.

The number of works posted on this page will increase daily. Please come back from time to time to take a look.

Lumix Photography + FLUX 1.1 PRO Ultra + Lrc

Dec. 18, 2024

(c) Akira Obata

Lumix Photography + FLUX 1.1 PRO Ultra + Lrc

Dec. 17, 2024

(c) Akira Obata

画像生成AIを使い始めたのは残暑が厳しい9月だった。あと二週間ほどで4ヶ月間になる。

そもそも、夏の厳しい暑さで体力が消耗し、重い撮影機材を持って被写体を求め歩くことが困難になったからだ。

さらに数年前から長時間の歩行が困難になっていた。75歳ともなると、体の機能が衰えることが必然だろうと、呑気に考えていたが、医者はあろうことか「パーキンソン病の疑いがある」などと脅しやがった。冗談じゃない!私はまだまだ被写体を求めて歩き続ける覚悟だ。

薬はすべてゴミ箱に直行、食事療法に専念した。

そう簡単に壊れてはたまらない。現在は普通の生活に支障はない。カメラ片手に再び歩き彷徨っている。

さて、本題はそんなことじゃない。使い始めた画像生成AIを、いかに自分の表現に役立てるか、飼い慣らすかということだ。

はっきり言ってしまえば、私が表現したいことと、AI君が出してくる画像との間には常に大きな隔たりがある。要するに私にとってAIはバカなのだ。プロンプトを学び、研究を重ねたところで、現在のAIが出してくる画像にはパターンがあり、薄っぺらで面白くない。

なぜか?

答えは単純だ。

AIには情緒がない、創作の原点とも言える原風景のようなものはAIとは無縁だからだろう。

であるなら、自分で描いたり撮影した作品を土台にすることから始めたらどうだ。

Text2imageあるいはimage2imageのパラダイムを実行する前段階に、まず自己の作品をAIに読み込ませる。

読み込ませた作品の上に、プロンプトで指示した画像を乗せる。それであれば、生成画像に自己のイメージを溶け込ませることが可能だ。最終的にはキャプチャー1やLightroom Classic、Photoshop時としてLiminar AIなどが手助けをしてくれている。

とは言っても、満足できる結果を得るためには、それなりの試行錯誤は必要だ。

大雑把な説明だが、このページでは以上の考えに基づいて作成した作品を掲載する。

掲載作品は日々、増えていきます。時々、見に来てください。

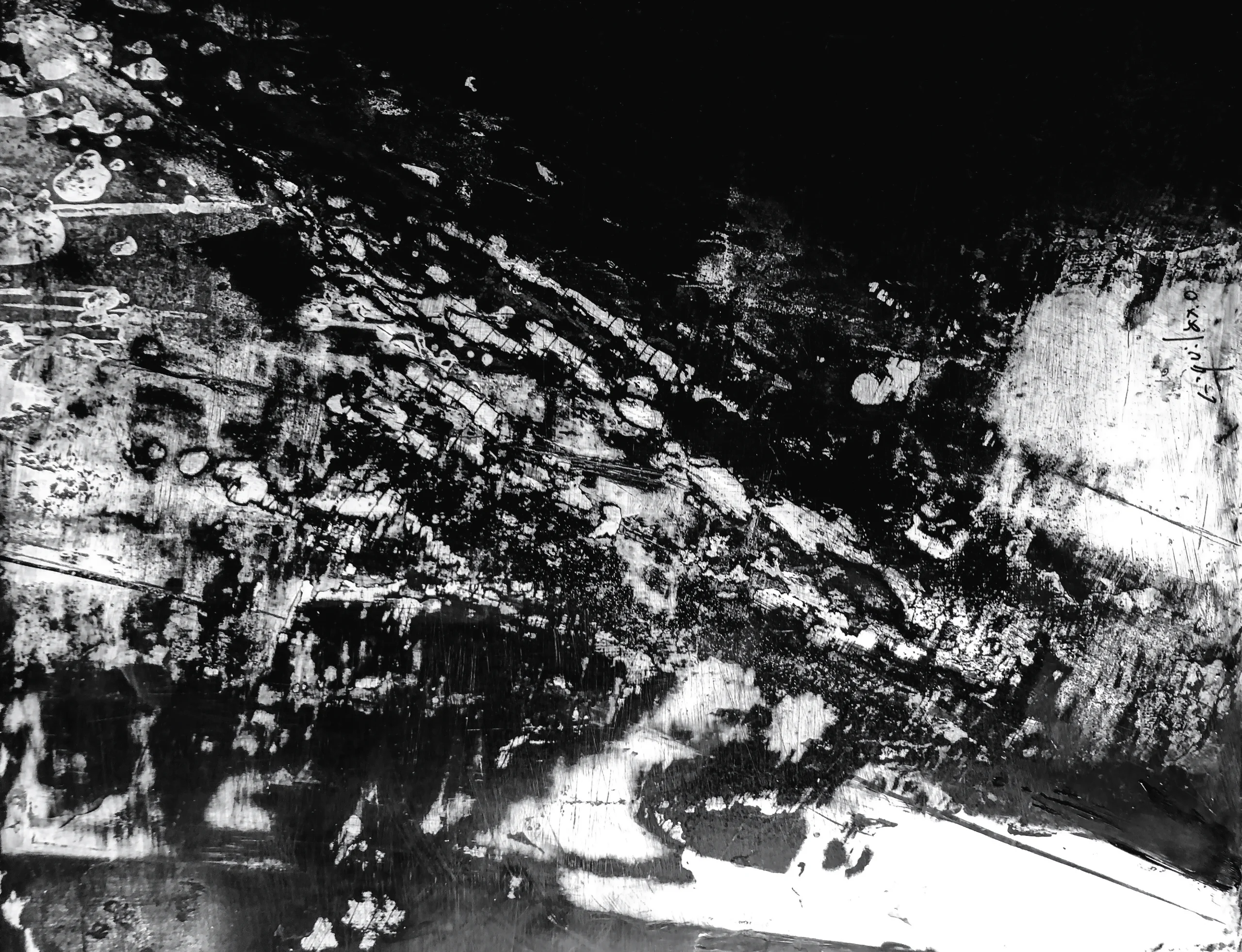

The following oil painting is the original image for the “blueprint” = AI image generation of the three works above; it was created in 2019 and painted with homemade carbon black paint on a silver foil base.

It is signed “Aquilax-O” on the lower right.

上の3枚の作品の「設計図」=AI画像生成の元になる画像が次の油絵です。2019年に制作したもので、銀箔の下地に自作のカーボンブラック絵の具で描いたものです。

右下に「Aquilax-O」のサインがあります。

AI image generation will train this image to serve as the foundation blueprint.

The oil painting image is rotated 90 degrees counterclockwise for horizontal positioning in the image generation, as shown below.

AI画像生成ではこの画像を学習させて土台となる設計図とします。

画像生成では横位置にするために油絵の画像は次のように反時計回りで90度回転させてあります。

I loaded this image into the image generation AI Flux, gave the prompts above to this image, and the three images I mentioned earlier were completed.

画像生成AI Fluxにこの画像を読み込ませ、このイメージに上にプロンプトで指示を与え、先ほどの3枚のイメージが完成しました。